模式识别

¥ 66.8 7.5折 ¥ 89 全新

库存23件

送至北京市朝阳区

运费快递 ¥6.00

作者吴建鑫 著

出版社机械工业出版社

ISBN9787111766674

出版时间2025-01

装帧平装

开本其他

定价89元

货号18000401

上书时间2025-03-16

评价168好评率 100%

- 最新上架

商品详情

- 品相描述:全新

- 商品描述

-

目录

目录<br />前言<br />符号表<br />第一部分 概述<br />第 1 章 绪论 2<br />1.1 样例: 自动驾驶 3<br />1.2 模式识别与机器学习 5<br />1.2.1 一个典型的模式识别流程 5<br />1.2.2 模式识别与机器学习8<br />1.2.3 评估、部署和细化 9<br />1.3 本书的结构 10<br />习题 12<br />第 2 章 数学背景知识 15<br />2.1 线性代数 15<br />2.1.1 内积、范数、距离和正交性16<br />2.1.2 角度与不等式 16<br />2.1.3 向量投影 17<br />2.1.4 矩阵基础 18<br />2.1.5 矩阵乘法 19<br />2.1.6 方阵的行列式与逆20<br />2.1.7 方阵的特征值、特征向量、秩和迹 22<br />2.1.8 奇异值分解 23<br />2.1.9 (半) 正定实对称矩阵 24<br />2.2 概率 25<br />2.2.1 基础 25<br />2.2.2 联合分布、条件分布与贝叶斯定理 27<br />VIII 模式识别<br />2.2.3 期望与方差/协方差矩阵 28<br />2.2.4 不等式 30<br />2.2.5 独立性与相关性 30<br />2.2.6 正态分布 31<br />2.3 优化与矩阵微积分 32<br />2.3.1 局部极小、必要条件和矩阵微积分 33<br />2.3.2 凸优化与凹优化 34<br />2.3.3 约束优化和拉格朗日乘子法36<br />2.4 算法复杂度 37<br />2.5 阅读材料 38<br />习题 39<br />第 3 章 模式识别系统概述 42<br />3.1 人脸识别 42<br />3.2 一个简单的最近邻分类器 43<br />3.2.1 训练或学习 43<br />3.2.2 测试或预测 44<br />3.2.3 最近邻分类器 44<br />3.2.4 k-近邻 46<br />3.3 丑陋的细节 46<br />3.4 制定假设并化简 49<br />3.4.1 设计工作环境与设计复杂算法 49<br />3.4.2 假设与简化 50<br />3.5 一种框架 54<br />3.6 阅读材料 55<br />习题 56<br />第 4 章 评估 58<br />4.1 简单情形中的准确率和错误率 58<br />4.1.1 训练与测试误差 59<br />4.1.2 过拟合与欠拟合 60<br />4.1.3 使用验证集来选择超参数62<br />4.1.4 交叉验证 63<br />4.2 最小化代价/损失 64<br />4.2.1 正则化 65<br />4.2.2 代价矩阵 66<br />目 录 IX<br />4.2.3 贝叶斯决策理论 67<br />4.3 不平衡问题中的评估67<br />4.3.1 单个类别内的比率67<br />4.3.2 ROC 曲线下的面积 69<br />4.3.3 查准率、查全率和 F 值 70<br />4.4 我们能达到 100%的准确率吗? 72<br />4.4.1 贝叶斯错误率 72<br />4.4.2 真实标记 73<br />4.4.3 偏置-方差分解 74<br />4.5 对评估结果的信心 77<br />4.5.1 为什么要取平均?77<br />4.5.2 为什么要报告样本标准差?78<br />4.5.3 比较两个分类器 79<br />4.6 阅读材料 84<br />习题 84<br />第二部分 与领域知识无关的特征提取<br />第 5 章 主成分分析 90<br />5.1 动机 90<br />5.1.1 维度与内在维度 90<br />5.1.2 降维 92<br />5.1.3 PCA 与子空间方法92<br />5.2 PCA 降维到零维子空间 93<br />5.2.1 想法-形式化-优化实践 93<br />5.2.2 一个简单的优化 94<br />5.2.3 一些注释 94<br />5.3 PCA 降维到一维子空间 95<br />5.3.1 新的形式化 95<br />5.3.2 最优性条件与化简96<br />5.3.3 与特征分解的联系97<br />5.3.4 解98<br />5.4 PCA 投影到更多维度99<br />5.5 完整的 PCA 算法 99<br />X 模式识别<br />5.6 方差的分析 100<br />5.6.1 从最大化方差出发的 PCA102<br />5.6.2 一种更简单的推导 103<br />5.6.3 我们需要多少维度呢? 103<br />5.7 什么时候使用或不用 PCA 呢? 104<br />5.7.1 高斯数据的 PCA 104<br />5.7.2 非高斯数据的 PCA 105<br />5.7.3 含异常点数据的 PCA 106<br />5.8 白化变换106<br />5.9 特征分解与 SVD 107<br />5.10 阅读材料 107<br />习题 107<br />第 6 章 Fisher 线性判别 111<br />6.1 用于二分类的 FLD 112<br />6.1.1 想法: 什么是隔得很远呢?112<br />6.1.2 翻译成数学语言 114<br />6.1.3 散度矩阵与协方差矩阵 115<br />6.1.4 两种散度矩阵以及 FLD 的目标函数 116<br />6.1.5 优化 117<br />6.1.6 等等, 我们有一条捷径! 118<br />6.1.7 二分类问题的 FLD118<br />6.1.8 陷阱: 要是 S_W 不可逆呢? 119<br />6.2 用于多类的 FLD 120<br />6.2.1 稍加修改的符号和 S_W 120<br />6.2.2 S_B 的候选 121<br />6.2.3 三个散度矩阵的故事 121<br />6.2.4 解 122<br />6.2.5 找到更多投影方向 122<br />6.3 阅读材料123<br />习题 123<br />目 录 XI<br />第三部分 分类器与其他工具<br />第 7 章 支持向量机 128<br />7.1 SVM 的关键思想 128<br />7.1.1 简化它! 简化它! 简化它!129<br />7.1.2 查找最大 (或较大) 间隔的分类器 130<br />7.2 可视化并计算间隔 131<br />7.2.1 几何的可视化 131<br />7.2.2 将间隔作为优化来计算 132<br />7.3 最大化间隔 133<br />7.3.1 形式化 133<br />7.3.2 各种简化 134<br />7.4 优化与求解 136<br />7.4.1 拉格朗日函数与 KKT 条件 136<br />7.4.2 SVM 的对偶形式137<br />7.4.3 最优的 b 值与支持向量138<br />7.4.4 同时考虑原始形式与对偶形式 140<br />7.5 向线性不可分问题和多类问题的扩展 141<br />7.5.1 不可分问题的线性分类器141<br />7.5.2 多类 SVM 143<br />7.6 核 SVM144<br />7.6.1 核技巧 145<br />7.6.2 Mercer 条件与特征映射146<br />7.6.3 流行的核函数与超参数 147<br />7.6.4 SVM 的复杂度、权衡及其他 149<br />7.7 阅读材料149<br />习题 150<br />第 8 章 概率方法 155<br />8.1 思考问题的概率路线155<br />8.1.1 术语 155<br />8.1.2 分布与推断 156<br />8.1.3 贝叶斯定理 157<br />8.2 各种选择157<br />8.2.1 生成式模型与判别式模型158<br />XII 模式识别<br />8.2.2 参数化与非参数化 158<br />8.2.3 该如何看待一个参数呢?159<br />8.3 参数化估计 160<br />8.3.1 最大似然 160<br />8.3.2 最大后验 162<br />8.3.3 贝叶斯 162<br />8.4 非参数化估计 165<br />8.4.1 一个一维的例子 165<br />8.4.2 直方图近似中存在的问题168<br />8.4.3 让你的样本无远弗届 168<br />8.4.4 核密度估计 169<br />8.4.5 带宽选择 170<br />8.4.6 多变量 KDE 171<br />8.5 做出决策172<br />8.6 阅读材料172<br />习题 173<br />第 9 章 距离度量与数据变换176<br />9.1 距离度量和相似度度量 176<br />9.1.1 距离度量 177<br />9.1.2 向量范数和度量 178<br />9.1.3 ?_p 范数和?_p 度量 178<br />9.1.4 距离度量学习 181<br />9.1.5 均值作为一种相似度度量182<br />9.1.6 幂平均核 185<br />9.2 数据变换和规范化 186<br />9.2.1 线性回归 186<br />9.2.2 特征规范化 188<br />9.2.3 数据变换 189<br />9.3 阅读材料192<br />习题 192<br />第 10 章 信息论和决策树 198<br />10.1 前缀码和霍夫曼树198<br />10.2 信息论基础 199<br />10.2.1 熵和不确定性 200<br />目 录 XIII<br />10.2.2 联合和条件熵 200<br />10.2.3 互信息和相对熵 201<br />10.2.4 一些不等式 202<br />10.2.5 离散分布的熵 204<br />10.3 连续分布的信息论204<br />10.3.1 微分熵 204<br />10.3.2 多元高斯分布的熵 206<br />10.3.3 高斯分布是最大熵分布208<br />10.4 机器学习和模式识别中的信息论 210<br />10.4.1 最大熵 210<br />10.4.2 最小交叉熵 211<br />10.4.3 特征选择 212<br />10.5 决策树 213<br />10.5.1 异或问题及其决策树模型213<br />10.5.2 基于信息增益的结点划分215<br />10.6 阅读材料 217<br />习题 217<br />第四部分 处理变化多端的数据<br />第 11 章 稀疏数据和未对齐数据 222<br />11.1 稀疏机器学习 222<br />11.1.1 稀疏 PCA? 222<br />11.1.2 使用 ?_1 范数诱导稀疏性 223<br />11.1.3 使用过完备的字典 227<br />11.1.4 其他一些相关的话题 229<br />11.2 动态时间规整 230<br />11.2.1 未对齐的时序数据 231<br />11.2.2 思路 (或准则) 232<br />11.2.3 可视化和形式化 233<br />11.2.4 动态规划 234<br />11.3 阅读材料 237<br />习题 238<br />XIV 模式识别<br />第 12 章 隐马尔可夫模型 242<br />12.1 时序数据与马尔可夫性质 242<br />12.1.1 各种各样的时序数据和模型 242<br />12.1.2 马尔可夫性质 244<br />12.1.3 离散时间马尔可夫链 245<br />12.1.4 隐马尔可夫模型 247<br />12.2 HMM 学习中的三个基本问题 249<br />12.3 α、β 和评估问题 250<br />12.3.1 前向变量和算法 250<br />12.3.2 后向变量和算法 252<br />12.4 γ、δ、ψ 和解码问题255<br />12.4.1 γ 和独立解码的最优状态255<br />12.4.2 δ、ψ 和联合解码的最优状态 256<br />12.5 ξ 和 HMM 参数的学习 258<br />12.5.1 Baum-Welch: 以期望比例来更新 λ 259<br />12.5.2 如何计算 ξ 259<br />12.6 阅读材料 262<br />习题 262<br />第五部分 高阶课题<br />第 13 章 正态分布 268<br />13.1 定义268<br />13.1.1 单变量正态分布 268<br />13.1.2 多元正态分布 269<br />13.2 符号和参数化形式271<br />13.3 线性运算与求和 272<br />13.3.1 单变量的情形 272<br />13.3.2 多变量的情形 273<br />13.4 几何和马氏距离 274<br />13.5 条件作用 275<br />13.6 高斯分布的乘积 277<br />13.7 应用 I: 参数估计 278<br />13.7.1 最大似然估计 278<br />目 录 XV<br />13.7.2 贝叶斯参数估计 279<br />13.8 应用 II: 卡尔曼滤波280<br />13.8.1 模型 280<br />13.8.2 估计 281<br />13.9 在本章中有用的数学282<br />13.9.1 高斯积分 282<br />13.9.2 特征函数 284<br />13.9.3 舒尔补 & 矩阵求逆引理285<br />13.9.4 向量和矩阵导数 286<br />习题 287<br />第 14 章 EM 算法的基本思想 291<br />14.1 GMM: 一个工作实例 291<br />14.1.1 高斯混合模型 291<br />14.1.2 基于隐变量的诠释 293<br />14.1.3 假若我们能观测到隐变量, 那会怎样? 294<br />14.1.4 我们可以模仿先知吗?294<br />14.2 EM 算法的非正式描述 295<br />14.3 期望最大化算法 296<br />14.3.1 联合非凹的不完整数据对数似然 296<br />14.3.2 (可能是) 凹的完整数据对数似然 297<br />14.3.3 通用 EM 的推导298<br />14.3.4 E 步和 M 步 300<br />14.3.5 EM 算法 301<br />14.3.6 EM 能收敛吗? 301<br />14.4 EM 用于 GMM 302<br />14.5 阅读材料 305<br />习题 306<br />第 15 章 卷积神经网络308<br />15.1 预备知识 308<br />15.1.1 张量和向量化 309<br />15.1.2 向量微积分和链式法则310<br />15.2 CNN 概览 310<br />15.2.1 结构 311<br />15.2.2 前向运行 312<br />XVI 模式识别<br />15.2.3 随机梯度下降 312<br />15.2.4 误差反向传播 314<br />15.3 层的输入、输出和符号 315<br />15.4 ReLU 层 315<br />15.5 卷积层 317<br />15.5.1 什么是卷积? 317<br />15.5.2 为什么要进行卷积? 320<br />15.5.3 卷积作为矩阵乘法 321<br />15.5.4 克罗内克积 323<br />15.5.5 反向传播: 更新参数 325<br />15.5.6 更高维的指示矩阵 326<br />15.5.7 反向传播: 为前一层准备监督信号 327<br />15.5.8 用卷积层实现全连接层329<br />15.6 汇合层 330<br />15.7 案例分析: VGG16

为你推荐

龙族全集

九五品阜阳

¥186.50

新刻绣像批评金瓶梅

全新苏州

¥2300.00

孙子兵法

九五品北京

¥5.00

浮生物语大画集

九品安阳

¥8.00

毛泽东军事文选

八五品石家庄

¥175.00

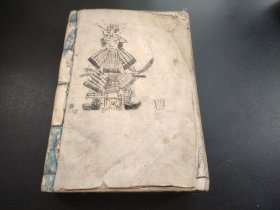

线装古籍1833年《永代大杂书万历大成》册全,超厚本,天文 地理自然 五行,精美木版画 须弥图 伏义河图 浑天图 24节日 出行 吉日 怀胎 解卦 吉凶化吉 三世相 ,和相图解 人相总论 出行方位 农稼门 针灸门 疾病门 裁缝门 居室门 等等

八品临沂

¥360.00

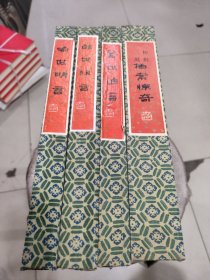

三言两拍全套(警世通言、喻世明言、醒世恒言、初刻二刻拍案惊奇)四函,外带盒装函套

九五品长春

¥120.00

毛泽东选集

八五品南阳

¥4000.00

哪咤之魔童降世电影纪念画集

八五品赣州

¥288.00

可爱过敏原

九品德阳

¥88.00

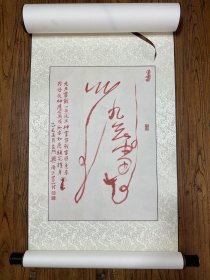

陈全林绘九天雷龙符

全新北京

¥400.00

国榷(第二册)2【精装大32开】

八品保定

¥60.00

【特装本】【甲骨文】心灵的哲学家:索伦·克尔凯郭尔不安的一生 〔英〕克莱尔·卡莱尔(Clare Carlisle) 著 马睿 译【特装工艺:书口喷绘+丝网印金】 存在主义之父 传记

全新北京

¥98.00

诸子集成

八五品石家庄

¥410.00

继续革命 乘胜前进

九五品烟台

¥3888.00

无产阶级*****胜利万岁(大32)

八品沈阳

¥150.00

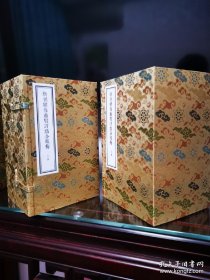

紫清全集(上下册)南宗五祖之一“白玉蟾全集”重新修订整理再版

全新北京

¥135.00

林*文选(上下)

八五品沈阳

¥1100.00

<联经中国史系列(平装版)·明史+清史 · 限量签名毛边本同编号合售> 叶高树签名+钤印+日期 · 限量编号毛边本(限量200册)台湾联经版《首崇满洲的多民族帝国:清史》+ 徐泓签名+钤印+日期 · 限量编号毛边本(限量200册)· 徐泓等 合著《华夏再造与多元转型:明史》(16开锁线胶订,一版一印)+赵珩签名钤印 ·香港中华书局版《逝者如斯:六十年知见学人侧记》(16开 一版一印)

全新北京

¥399.00

伤寒论临证指要-文献通考

八五品无锡

¥450.00

— 没有更多了 —

微信扫码逛孔网

无需下载

书已收到,新书,发货速度快,非常满意。

好评