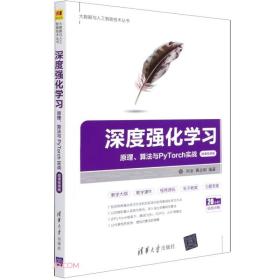

深度强化学习(原理算法与PyTorch实战微课视频版)/大数据与人工智能技术丛书

正版书籍支持开票

¥ 38.28 6.4折 ¥ 59.8 全新

库存30件

江苏无锡

认证卖家担保交易快速发货售后保障

作者刘全、黄志刚 编

出版社清华大学出版社

出版时间2021-08

版次1

装帧平装

货号文轩7.1

上书时间2024-07-01

- 在售商品 暂无

- 平均发货时间 16小时

- 好评率 暂无

- 店主推荐

- 最新上架

商品详情

- 品相描述:全新

图书标准信息

- 作者 刘全、黄志刚 编

- 出版社 清华大学出版社

- 出版时间 2021-08

- 版次 1

- ISBN 9787302578208

- 定价 59.80元

- 装帧 平装

- 开本 16开

- 页数 243页

- 【内容简介】

- 围绕着MDP模型,阐述动态规划、蒙特卡罗、动态规划等有穷表格式强化学习方法。在深度强化学习框架PyTorch下,阐述DQN,DDDPG,A3C等算法。本书以实例为导向,深度浅出地讲解相关算法。全书采用完整的数学体系,各章内容循序渐进,严谨地讲授强化学习的理论基础,主要定理均给出证明过程。基于理论讲解强化学习算法,覆盖了所有主流强化学习算法,包括资格迹等经典算法和深度确定性梯度策略等深度强化学习算法。适合本科以上的人工智能相关专业学生及工程人员。

- 【目录】

-

第一部分:预备知识及环境安装

第1章 深度强化学习概述

1.1 引言

1.2 深度学习

1.3 强化学习

1.4 深度强化学习

1.5 小结

1.6 习题

第2章 环境的配置

2.1 PyTorch简介

2.2 PvTorch和TensorFlow

2.3 强化学习的开发环境

2.3.1 Anaconda环境搭建

2.3.2 Anaconda环境管理

2.3.3 PyTorch的安装

2.3.4 Jupyter Notebook的安装

2.3.5 Jupyter Notebook的使用

2.3.6 Gym的安装

2.3.7 Gym案例

2.4 小结

2.5 习题

第二部分:表格式强化学习

第3章 数学建模

3.1 马尔可夫决策过程

3.2 基于模型与无模型

3.3 求解强化学习任务

3.3.1 策略

3.3.2 奖赏与回报

3.3.3 值函数与贝尔曼方程

3.3.4 最优策略与最优值函数

3.4 探索与利用

3.5 小结

3.6 习题

第4章 动态规划法

4.1 策略迭代

4.1.1 策略评估

4.1.2 策略迭代

4.2 值迭代

4.3 广义策略迭代

4.4 小结

4.5 习题

第5章 蒙特卡洛法

5.1 蒙特卡洛法的基本概念

5.1.1 MC的核心要素

5.1.2 MC的特点

5.2 蒙特卡洛预测

5.3 蒙特卡洛评估

5.4 蒙特卡洛控制

5.4.1 基于探索始点的蒙特卡洛控制

5.4.2 同策略蒙特卡洛控制

5.4.3 异策略与重要性采样

5.4.4 蒙特卡洛中的增量式计算

5.4.5 异策略蒙特卡洛控制

5.5 小结

5.6 习题

第6章 时序差分法

6.1 时序差分预测

6.2 时序差分控制圆

6.2.1 Sarsa算法

6.2.2 Q-Learning算法

6.2.3 期望sarsa算法

6.3 最大化偏差与Double Q-Learning

6.3.1 最大化偏差

6.3.2 Double Q-Learning

6.3.3 Double Q-Learning

6.4 DP、MC和TD算法的关系

6.4.1 穷举式遍历与轨迹采样

6.4.2 期望更新与采样更新

6.5 小结

6.6 习题

第7章 n-步时序差分法

7.1.l n-步TD预测及资格迹回

7.1.1 n-步TD预测

7.1.2 前向TD(λ)算法

7.1.3 后向TD(λ)算法

7.2 n-步TD控制及其资格迹实现

7.2.1 同策略n-步Sarsa算法

7.2.2 Sarsa(λ)算法

7.2.3 异策略n-步Sarsa算法

7.2.4 n-步Tree Backup算法

7.3 小结

7.4 习题

第8章 规划和蒙特卡洛树搜索

8.1 模型、学习与规划回

8.1.1 模型

8.1.2 学习

8.1.3 规划

8.2 Dyna-Q结构及其算法改进回

8.2.1 Dyna-Q架构

8.2.2 优先遍历

8.2.3 模拟模型的错误性

8.3 决策时间规划

8.3.1 启发式搜索

8.3.2 预演算法

8.3.3 蒙特卡洛树搜索

8.4 小结

8.5 习题

第三部分:深度强化学习

第9章 深度学习

9.1 传统神经网络圆

9.1.1 感知器神经元

9.1.2 激活函数

9.2 反向传播算法

9.2.1 前向传播

9.2.2 权重调整

9.2.3 BP算法推导

9.3 卷积神经网络

9.3.1 卷积神经网络核心思想

9.3.2 卷积神经网络结构

9.4 小结

9.5 习题

第10章 PyTorch与神经网络

10.1 PyTorch扣的Tensor

10.1.1 直接构造法

10.1.2 间接转换法

10.1.3 Tensor的变换

10.2 自动梯度计算

10.2.1 标量对标量的自动梯度计算

10.2.2 向量对向量的自动梯度计算

10.2.3 标量对向量(或矩阵)的自动梯度计算

10.3 神经网络的模型搭建和参数优化

10.3.1 模型的搭建

10.3.2 激活函数

10.3.3 常用的损失函数

10.3.4 模型的保存和重载

10.4 小结

10.5 习题

第ll章 深度Q网络

11.1 DQN算法

11.1.1 核心思想

11.1.2 训练算法

11.1.3 实验结果与分析

11.2 Double DQN算法

11.2.1 核心思想

11.2.2 实验结果与分析

11.3 Prioritized DQN

11.3.1 核心思想

11.3.2 训练算法

11.3.3 实验结果与分析

11.4 Dueling DQN

11.4.1 训练算法

11.4.2 实验结果与分析

11.5 小结

11.6 习题

第12章 策略梯度法

12.1 随机策略梯度法

12.1.1 梯度上升算法

12.1.2 策略梯度法与值函数逼近法的比较

12.2 策略优化方法

12.2.1 情节式策略目标函数

12.2.2 连续式策略目标函数

12.2.3 策略梯度定理

12.3 策略表达形式

12.3.1 离散动作空间策略参数化

12.3.2 连续动作空间策略参数化

1

点击展开

点击收起

— 没有更多了 —

以下为对购买帮助不大的评价